白话架构(2)- 从30吨“电老虎”到掌心设备:四代计算机的迭代史诗

戈登·摩尔:摩尔定律终将失效,但创新不会停止……未来需要材料、架构、算法的协同突破。

在前一篇文章中,我们追溯了计算机的起源,见证了数字时代的萌芽。今天,我们将顺着时间线,走进四代计算机的演化历程——从体积庞大的电子管计算机,到如今融入生活的个人电脑,每一次迭代的背后,都是技术与创新的双重突破,更是架构体系不断完善的过程。

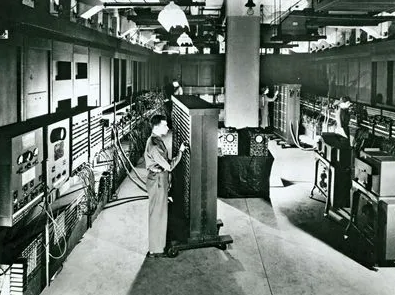

第一代(1946 年起):电子管时代,30 吨“电老虎”开启计算元年

1946 年,第一代计算机的代表——ENIAC 诞生了。它的全称是 Electronic Numerical Integrator and Computer,中文译为电子数值积分计算机。这串冗长的英文缩写,是不是像极了漫威神盾局(S.H.I.E.L.D.)的命名风格?神盾局全称Strategic Homeland Intervention, Enforcement and Logistics Division,中文是“国土战略防御攻击与后勤保障局”,两者都藏着“低调的霸气”🤣。

提到 ENIAC,就绕不开冯·诺依曼。他在 ENIAC 研发后期加入顾问团队,随后和团队一起确立了影响至今的冯·诺依曼架构。

冯·诺依曼一眼看穿了 ENIAC 的致命问题:它靠物理插线方式编程,性能极低。而冯·诺依曼架构的核心创新——“存储器”,正是为解决这个痛点而生。

这种物理插线编程,其实是最原始的二进制实现:线路连通代表“1”,线路未连通代表“0”。在 ENIAC 时代,电子管是核心电子元件,体积大到肉眼可见。

图:电子管

第一代计算机的特点堪称粗犷:体积庞大、耗电量大、运算速度慢。

就说 ENIAC,占地 170 平方米(差不多是半个篮球场大小),重达 30 吨。为了给它供电,专门建了一座大型变电站。据说它一开机,附近地区的电灯都会变暗——这只“电老虎”,就是当时计算机的真实模样。

也难怪在那个年代,你走进一个房间问“计算机在哪”,得到的回答会是:“整个房间都是它。”

图:ENIAC

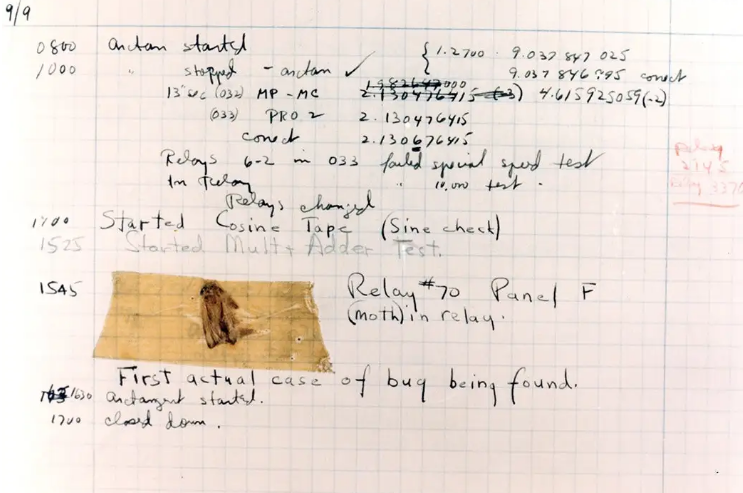

和冯·诺依曼架构齐名的哈佛架构,起源于Mark I计算机,迭代到第二代就是Mark II。而它的出名,还和一个有趣的故事有关。

1947 年 9 月 9 日,美国海军编程员格蕾斯·哈珀团队在哈佛大学测试Mark II时,发现一只飞蛾(英文:bug)被困在第 70 号继电器上,导致短路故障。这被记录为人类历史上第一个计算机 bug。

从此,计算机的故障、漏洞都被称为bug。不妨畅想一下:如果当时卡住的是一只瓢虫(英文:ladybug),说不定现在我们吐槽的漏洞就叫ladybug🐞 了。

图:世界上第一个计算机 bug

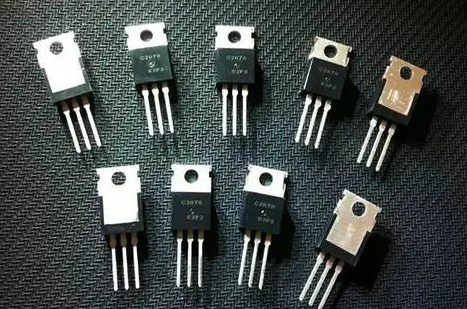

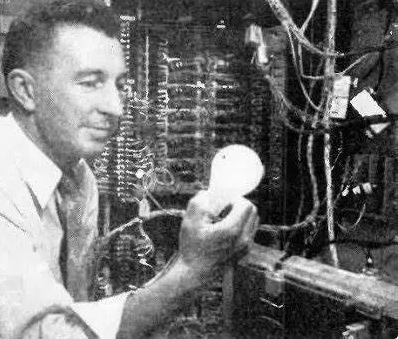

第二代(1954 年起):晶体管登场,体积大减+性能飞跃

ENIAC 的“笨重”,注定只是过渡。1947 年 12 月 16 日,美国新泽西州贝尔实验室,威廉·肖克利、约翰·巴顿和沃特·布拉顿成功制造出第一个晶体管——这颗小小的元件,直接拉开了第二代计算机的序幕。

对比电子管,晶体管的体积堪称“迷你”:电子管长度多在几厘米到十几厘米,直径也有几厘米;而晶体管长度通常在 1 厘米以内,宽度和厚度仅几毫米。

图:晶体管

体积的成倍缩小,意味着相同空间能容纳更多元件;更多元件能实现更复杂的逻辑;更复杂的逻辑,直接带来性能的大幅提升。晶体管取代电子管,成为第二代计算机的核心元件。

1954 年,美国贝尔实验室研制出第一台晶体管计算机TRADIC(全称 Transistor Digital Computer,中文“晶体管数字计算机”)。

图:TRADIC

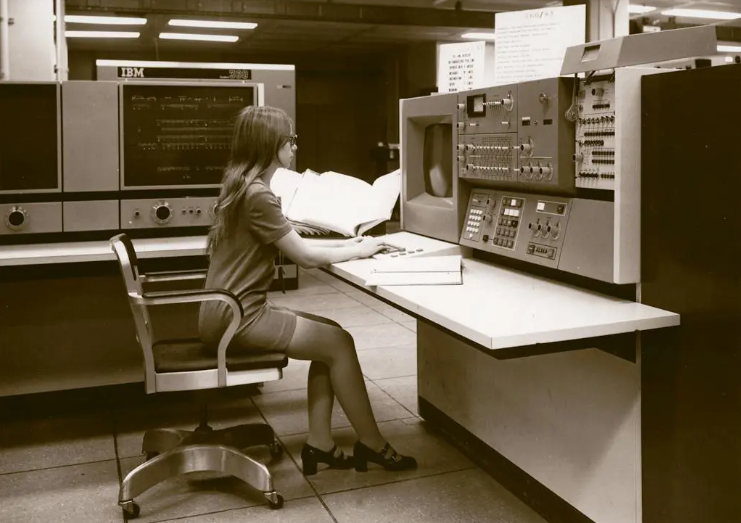

1959 年,IBM 推出第一台商用晶体管计算机IBM 7090,彻底推动计算机从科研走向实用。

图:IBM 7090

硬件的进步,也催生了软件的发展。在第二代计算机前后,FORTRAN(1957 年)、LISP(1958 年)、COBOL(1959 年)等高级编程语言相继诞生——要是没有硬件性能的提升,这些复杂语言根本无法运行。

和第一代电子管计算机比,IBM 7090 的优势肉眼可见:运算速度达每秒 50 万次浮点运算,可靠性显著增强,体积和功耗却大大降低。当年科研人员用它参与卫星发射计算,助力卫星成功入轨后,IBM 7090 直接在航空航天领域“一炮而红”。

这一阶段,计算机仍遵循冯·诺依曼架构,按“取指-译码-执行”的串行流程工作,也就是单指令流、单数据流(SISD)。但我们不难推断,未来必然会出现单指令流多数据流(SIMD)、多指令流多数据流(MIMD)的新模式。

同时,“中央处理器(CPU)”的早期概念也开始出现,不过此时的 CPU 还由多个分立电路板组成,尚未成为独立元器件。

第三代(1964 年起):集成电路革命,IBM 360 的里程碑意义

晶体管的迭代还在继续,更大的突破已经在路上——集成电路来了�。

1958 年 9 月 12 日,杰克·基尔比成功制造出世界上第一块锗基集成电路,包含 1 个晶体管、3 个电阻和 1 个电容,被称为单片电路。2000 年,基尔比凭借这个发明获得诺贝尔物理学奖。

几乎同时,罗伯特·诺伊斯在仙童半导体提出基于平面工艺的集成电路,用二氧化硅层实现元件间的绝缘和连接,并于 1960 年领导团队造出首个可量产的硅基集成电路。

后来,诺伊斯联合戈登·摩尔(摩尔定律提出者)在 1968 年创办了英特尔——这家公司后来的故事,就无人不晓了。

进入 20 世纪 60 年代,材料科学、光刻技术、器件结构的协同进步,让集成电路从“概念”走向“量产”,中小规模集成电路(SSI、MSI)相继出现。

小规模集成电路(SSI):每个芯片含有的电子元器件少于 100 个,主要实现逻辑门、触发器等基础功能,比如常见的 74 系列逻辑门芯片。

图:74 芯片示意图

中规模集成电路(MSI):元器件数目在 100 到 3000 个之间,能实现计数器、译码器等复杂逻辑功能。

在中小规模集成电路的基础上,第三代计算机正式诞生。1964 年,IBM 推出的 IBM 360 大型计算机系列,成为这一代的标志性产品。

IBM 360的研发堪称“史诗级项目”:投入了海量人力物力,集结众多顶尖科学家和工程师,规模大到很多参与者都不知道自己负责的部分在系统中的位置。

但它的创新足以改变行业:统一的指令集架构让软件可兼容同系列计算机;模块化设计能组合成适��配不同场景的系统。凭借这些优势,IBM 360 推动了计算机产业爆发,促进了信息技术普及,还培养了大批计算机人才。

图:IBM 360

有趣的是,IBM 360 硬件大获成功,但操作系统开发却成了“灾难”。在上一篇文章中我们提到,它的 IBM OS/360操作系统是首个大规模复杂软件,包含 500 万行代码、3000 人开发,最终超预算 5 倍、延期 4 年才发布。

这场“灾难”也成为推动软件工程发展的典型案例。无论是硬件的成功还是软件的反思,IBM 360 都堪称计算机史上的里程碑。

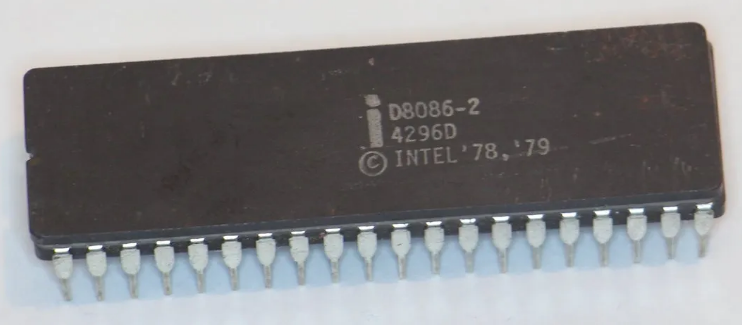

与此同时,CPU 也在快速演进:1971 年,首款计算器微处理器 Intel 4004 诞生(4 位、2300 个晶体管、主频 740kHz);1972 年,Intel 8008 成为计算机标准 CPU;1974 年,Intel 8080 被认为是第一个真正有用的 CPU,为个人计算机铺路;1978 年,Intel 8086 主导个人计算机市场,也预示着第四代计算机即将到来。

图:Intel 8086

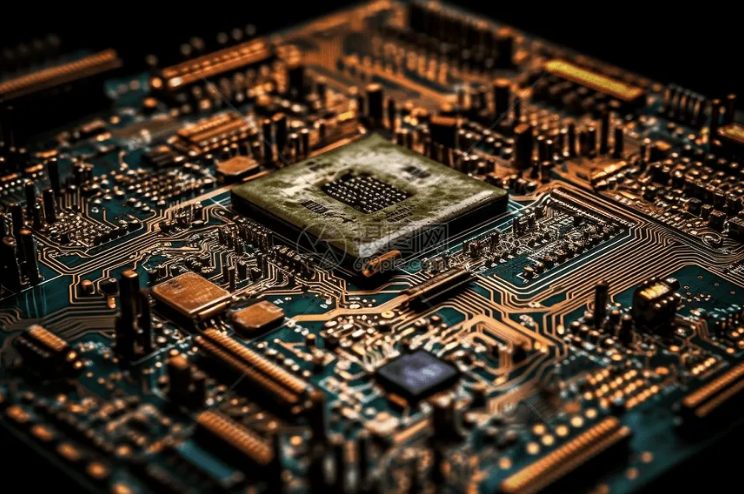

第四代(1981 年起):超大规模集成电路,个人计算机时代来临

光刻技术的突破,让同面积电路板能蚀刻更多电路;半导体制造工艺的完善,提升了晶体管的速度和可靠性。在这些技术支撑下,集成电路从中小规模升级为大规模(LSI)和超大规模(VLSI)——第四代计算机就此崛起,我们现在用的个人电脑,都属于这一代。

图:超大规模集成电路示意图

第四代计算机的典型代表,是 IBM PC 和苹果 Macintosh,它们共同开启了个人计算机的新时代。 1981 年,IBM 推出个人计算机(PC),采用 Intel 8088 微处理器(8086 的升级款)。关键的是,IBM 采用开放式架构,允许第三方厂商开发软硬件——这个早期的“开源式决定”,让 IBM PC 迅速占领市场,成为个人计算机的标准之一,还催生了庞大的软硬件生态。

图:IBM PC

1984 年,苹果推出 Macintosh 计算机,最大创新是图形用户界面(GUI)。在当时命令行界面主导的时代,图形界面更直观、更易操作,彻底改变了用户与计算机的交互方式,还推动了图形设计、桌面出版等领域的发展。

图:Macintosh

随着这两款产品的发布,计算机进入高速发展期,CPU 的迭代也按下“加速键”。1989 年,Intel 80486 芯片问世,它将 CPU、数学协处理器和 8KB 高速缓存集成在一颗芯片上,还首次在 80X86 系列中采用 RISC(精简指令集)技术,用突发总线提升内存交换速率——这就是“486 时代”,现代 CPU 基本都在此基础上迭代。 此后,指令集形成两大分支:CISC(复杂指令集)提升代码密度,成为 x86 架构的核心,主导个人计算市场;RISC(精简指令集)提升效率,被 ARM、MIPS 架构采用,主导移动设备市场。

架构的核心:冯·诺依曼的延续与摩尔定律的未来

从第一代到第四代,计算机的核心架构始终离不开冯·诺依曼架构。它将硬件划分为运算器、控制器、存储器、输入/输出装置四大核心,而 CPU 最终集成了其中的运算器和控制器——这一核心设计,贯穿了计算机发展的半个多世纪。

最后,我们回到戈登·摩尔。这位英特尔联合创始人在 1965 年《电子学》杂志上提出摩尔定律:集成电路上可容纳的晶体管数量,约每 18-24 个月增加一倍,同时成本下降一半。

制程工艺的不断缩小,让摩尔定律延续了数十年。但 2000 年后,单核性能触顶,多核与并行计算成为趋势,厂商开始推动多核 CPU(如 Intel Core 系列)和 GPU 协同计算。2006 年制程突破 26nm,Intel 推出 Core 2 Duo;2020 年制程达到 5nm,ARM 架构的 Apple M1问世,让摩尔定律继续“续命”。

但物理极限终究无法突破:一是量子隧穿效应,晶体管尺寸低于 3nm 时,电子可能“穿越”绝缘层导致漏电;二是热密度问题,芯片功耗密度接近核反应堆,散热成为瓶颈。摩尔定律或许终将迎来终点,但技术创新永远不会止步。

四代计算机的演化、CPU 的诞生与突破,离不开科学界和工业界的共同努力。软件工程的发展,也始终与硬件进步同频共振。

下一篇,我们将聚焦软件浪潮中的英雄人物,看看他们如何用代码构建数字世界的基石。敬请期待!